Fir d'Verbreedung vu sexuellem Mëssbrauchsmaterial fir Kanner (CSAM) ze bekämpfen, huet eng Koalitioun vun Top generativen AI Entwéckler - dorënner Google, Meta an OpenAI - versprach, Schutzschirmer ronderëm déi opkomende Technologie ëmzesetzen.

D'Grupp gouf vun zwee Net-Gewënn Organisatiounen zesumme gezunn: Kanner-Tech-Grupp Thorn an New York-baséiert All Tech is Human. Fréier als DNA Foundation bekannt, Thorn gouf 2012 vun de Schauspiller Demi Moore an Ashton Kutcher gestart.

De kollektive Versprieche gouf en Dënschdeg mat engem neien Thorn Bericht ugekënnegt, deen e "Safety by Design" Prinzip an der generativer AI Entwécklung plädéiert, déi d'Schafung vu sexuellem Mëssbrauchsmaterial (CSAM) iwwer de ganze Liewenszyklus vun engem AI Modell verhënneren.

"Mir fuerderen all Firmen, déi generativ AI Technologien a Produkter entwéckelen, ofsetzen, ënnerhalen a benotzen fir sech ze engagéieren fir dës Safety by Design Prinzipien z'adoptéieren an hir Engagement ze demonstréieren fir d'Schafung an d'Verbreedung vu CSAM, AIG-CSAM an aner sexuell Akte vu Kanner ze verhënneren. Mëssbrauch an Ausbeutung, "sot Thorn an enger Ausso.

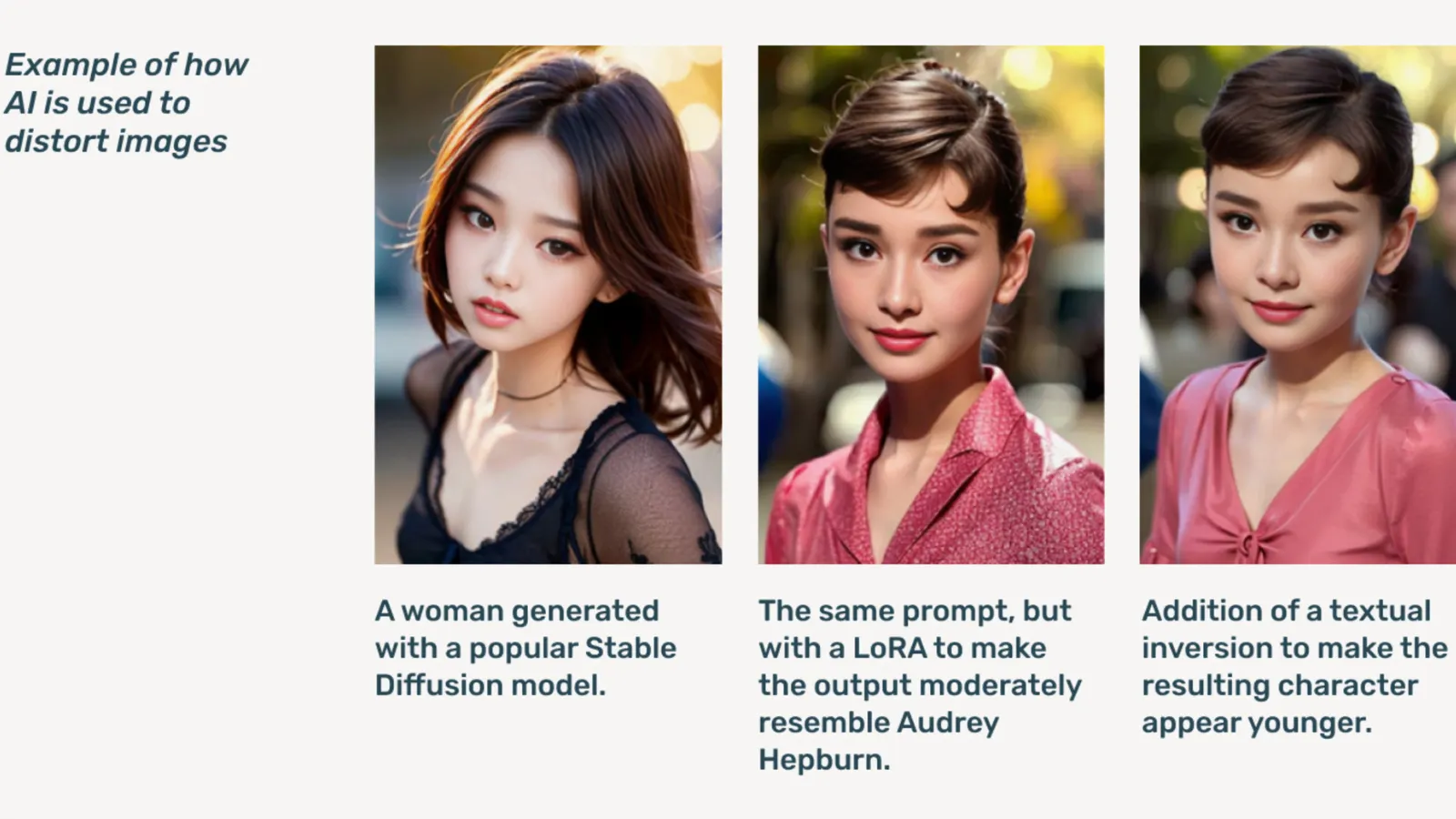

AIG-CSAM ass AI-generéiert CSAM, wat de Bericht illustréiert ka relativ einfach ze kreéieren.

Thorn entwéckelt Tools a Ressourcen déi sech fokusséiere fir Kanner vu sexuellem Mëssbrauch an Ausbeutung ze verteidegen. A sengem Impaktbericht vun 2022 huet d'Organisatioun gesot datt iwwer 824,466 Dateien mat Kannermëssbrauchmaterial fonnt goufen. D'lescht Joer huet Thorn méi wéi 104 Millioune Fichiere vu verdächtege CSAM gemellt eleng an den USA gemellt.

Scho e Problem online, déiffake Kannerpornographie ass an d'Luucht gaangen nodeems generativ AI Modeller ëffentlech verfügbar sinn, mat Stand-alone AI Modeller déi keng Cloud Servicer brauchen, déi op donkele Webforen zirkuléiert ginn.

Generativ AI, sot Thorn, mécht Volumen un Inhalt méi einfach wéi jee virdrun. Een eenzegt Kand Predator kéint potenziell massiv Volumen vu sexuellem Mëssbrauchsmaterial (CSAM) erstellen, inklusiv d'Upassung vun originelle Biller a Videoen an neien Inhalt.

"En Influx vun AIG-CSAM stellt bedeitend Risiken fir e scho besteierte Kannersécherheets-Ökosystem, d'Erausfuerderunge vun der Gesetzesvollzéier verschäerft fir existent Affer vu Mëssbrauch z'identifizéieren an ze retten, an nei Affer vu méi Kanner ze skaléieren," bemierkt Thorn.

Dem Thorn säi Bericht skizzéiert eng Serie vu Prinzipien déi generativ AI Entwéckler verfollegen fir ze verhënneren datt hir Technologie benotzt gëtt fir Kannerpornografie ze kreéieren, inklusiv verantwortlech Sourcen Trainingsdatesätze, Feedback Loops a Stressteststrategien integréieren, Inhaltsgeschicht benotzen oder "Provenance" mat adversarielle Mëssbrauch am Kapp, a verantwortlech hir jeeweileg AI Modeller hosten.

Anerer, déi de Verspriechen ënnerschreiwen, enthalen Microsoft, Anthropic, Mistral AI, Amazon, Stability AI, Civit AI, a Metaphysic, jidderee verëffentlecht haut separat Aussoen.

"Deel vun eisem Ethos bei Metaphysic ass verantwortlech Entwécklung an enger AI Welt, richteg, et geet ëm empowering, awer et ass iwwer Verantwortung," sot de Metaphysic Chef Marketing Offizéier Alejandro Lopez Decrypt. "Mir erkennen séier datt fir unzefänken an z'entwéckelen dat heescht wuertwiertlech déi meescht vulnérabel an eiser Gesellschaft ze schützen, déi Kanner sinn, a leider dat däischtersten Enn vun dëser Technologie, déi fir Kanner sexuell Mëssbrauch Material a Form vun déif gefälschte Pornographie benotzt gëtt. , dat ass geschitt."

Am Joer 2021 gestart, Metaphysic koum d'lescht Joer op d'Prominenz nodeems et opgedeckt gouf datt e puer Hollywood Stären, dorënner Tom Hanks, Octavia Spencer, an Anne Hathaway, Metaphysic Pro Technologie benotzt hunn fir d'Charakteristike vun hirer Ähnlechkeet ze digitaliséieren an enger Offer fir d'Besëtzer iwwer déi néideg Eegeschaften ze halen. en AI Modell ze trainéieren.

OpenAI refuséiert weider op d'Initiativ ze kommentéieren, amplaz ze liwweren Decrypt eng ëffentlech Ausso vu senger Kannersécherheetsleit Chelsea Carlson.

"Mir këmmeren eis déif ëm d'Sécherheet an d'verantwortlech Notzung vun eisen Tools, dofir hu mir staark Schutzschirmer a Sécherheetsmoossnamen an ChatGPT an DALL-E gebaut", sot de Carlson an enger Ausso. "Mir sinn engagéiert zesumme mam Thorn ze schaffen, All Tech is Human an déi breet Technologiegemeinschaft fir d'Sécherheet duerch Design Prinzipien z'erhalen an eis Aarbecht weider ze maachen fir potenziell Schued fir Kanner ze reduzéieren."

Decrypt aner Membere vun der Koalitioun erreecht hunn, awer net direkt erëm héieren.

"Bei Meta hu mir iwwer e Jorzéngt geschafft fir d'Leit online sécher ze halen. An där Zäit hu mir vill Tools a Fonctiounen entwéckelt fir potenziell Schued ze verhënneren an ze bekämpfen - a wéi Feinde sech ugepasst hunn fir eis Protectiounen z'evitéieren, hu mir och weider ugepasst, "sot Meta an enger preparéierter Ausso.

"Iwwer eise Produkter entdecken an ewechhuelen mir proaktiv CSAE Material duerch eng Kombinatioun vun Hash-passende Technologie, kënschtlech Intelligenz Klassifizéierer, a mënschlech Rezensiounen", huet de Google Vizepresident vu Vertrauens- a Sécherheetsléisungen Susan Jasper an engem Post geschriwwen. "Eis Politiken a Schutz sinn entwéckelt fir all Zorte vu CSAE z'entdecken, dorënner AI-generéiert CSAM. Wa mir exploitativ Inhalter identifizéieren, läschen mir et an huelen déi entspriechend Handlung, wat kann et un d'NCMEC mellen.

Am Oktober huet d'UK Iwwerwaachungsgrupp, d'Internet Watch Foundation, gewarnt datt AI-generéiert Kannermëssbrauchmaterial den Internet kéint "iwwerwältegend".

Editéiert vum Ryan Ozawa.

Bleift um Top vun der Krypto Neiegkeet, kritt alldeeglech Updates an Ärer Inbox.

Quell: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material